In diesem Artikel lesen Sie,

- für welche Einsatzzwecke sich High Performance Computing (HPC) aus der Public Cloud eignet,

- welche Voraussetzungen dafür erfüllt sein müssen und

- worauf Unternehmen dabei achten sollten.

Ob Belastungs-Simulationen im Maschinenbau, Genanalysen in der Medizin oder maschinelles Lernen im Bereich künstlicher Intelligenz: Hochkomplexe Prozesse erfordern extreme Rechenleistung. Während solche Berechnungen noch vor wenigen Jahren nur mit teurer Hardware von Supercomputern möglich waren, können Unternehmen entsprechende Kapazitäten mittlerweile bedarfsgerecht aus der Public Cloud buchen – zum Beispiel aus der Open Telekom Cloud. Damit nutzen Firmen hochspezialisierte und -performante Hardware genau nach Bedarf, so dass sie riesige Datenmengen in kürzester Zeit verarbeiten und komplexe Problemstellungen deutlich schneller als früher lösen können. Zudem sparen sie damit Aufbau und Betrieb eigener, teurer Hardware und damit hohe Fixkosten.

Doch bevor Unternehmen High Performance Computing (HPC) aus der Public Cloud nutzen, stellen sich einige wichtige Fragen:

- Wodurch unterscheidet sich HPC von herkömmlichen Public-Cloud-Ressourcen?

- Für welche Szenarien ist HPC sinnvoll – und für welche nicht?

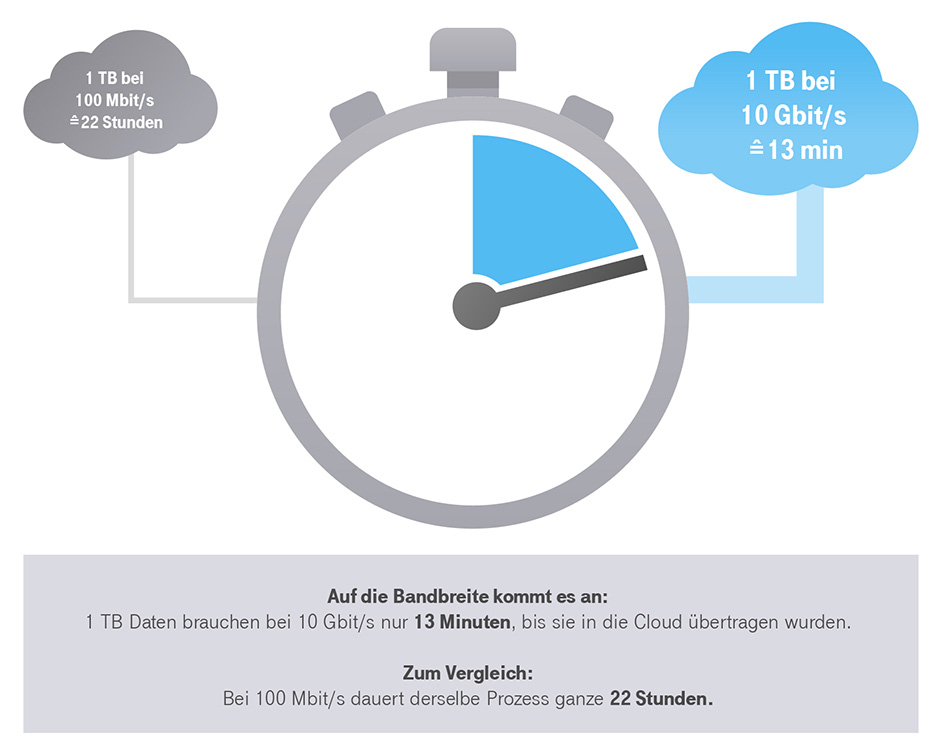

- Wie muss die Netzwerkverbindung dimensioniert sein?

- Welche Daten sollten in die Cloud – und welche nicht?

- Wo gibt es das beste Preis-Leistungs-Verhältnis?

- Welche Software und welche Zertifikate sind unverzichtbar?

- Und welche Rolle spielen Sicherheit und Datenschutz?