In diesem Fachbeitrag von High-Performance-Computing-Experte Alfred Geiger lesen Sie,

- welche unterschiedlichen Methoden es gibt, High Performance Computing mit der Public Cloud umzusetzen

- wie Unternehmen herausfinden, welche sich für Ihren Anwendungsfall am meisten lohnt

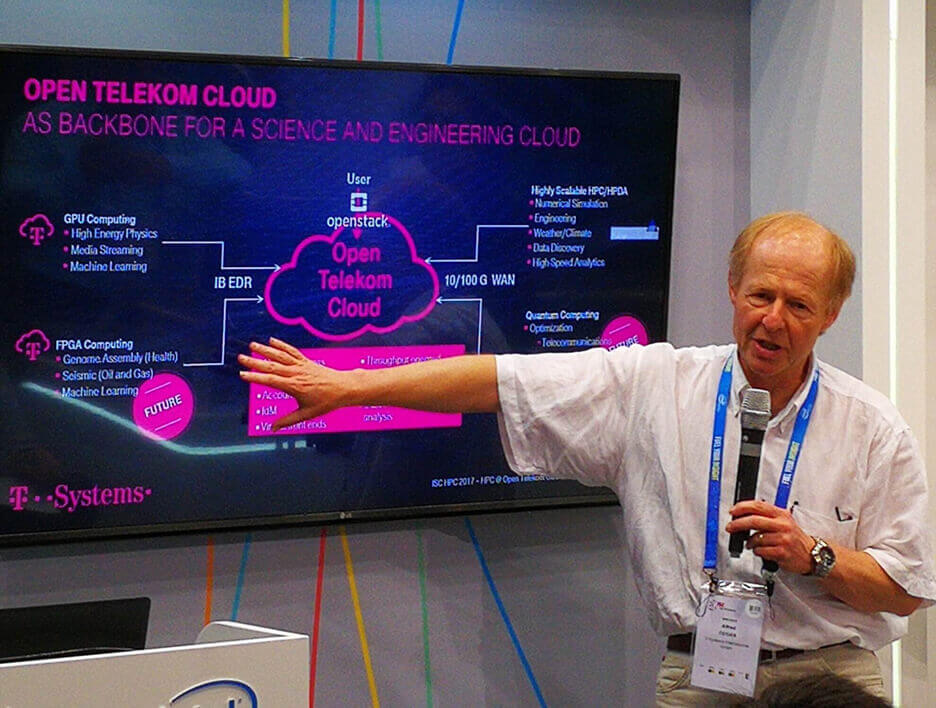

- und warum die Open Telekom Cloud im Vergleich zu anderen Public-Clouds auf vielen Ebenen das beste Angebot ist.

Mit welchem IT-Konzept lösen Unternehmen komplexe Problemstellungen am schnellsten? Eine allgemeine Antwort darauf lautet: mit dem Cloud-Bursting-Prinzip; also einer geschickten Kombination aus on-premises- und hoch performanter Public-Cloud-Rechenressourcen. On-premises deckt bestimmte Grundaufgaben ab, die skalierbaren High-Performance- Kapazitäten aus der Public Cloud kommen je nach Bedarf für entsprechende Lastspitzen zum Einsatz.

Beim Blick unter die Haube wird die Sache schon komplexer. Denn High Performance Computing (HPC) aus der Public Cloud bietet sehr vielfältige Ausprägungen. Daher sollten Unternehmen einige grundlegende Fakten zu diesem Thema kennen, denn nicht jede Technologie ist für jeden Anwendungsfall gleichgut geeignet.